技术型SEO(Technical SEO)是决定网站能否被搜索引擎正确抓取、索引与呈现的基础工作。本指南汇集了审计要点、逐项检查清单与可执行的实操建议,覆盖首选域名、SSL、抓取友好性、索引策略、渲染与性能优化等关键环节。无论你是刚入门的SEO从业者还是负责站点架构的工程师,本文都将提供清晰的优先级与落地步骤,帮助你快速定位并修复影响排名的技术问题。请从目录选择你关心的部分,或按顺序逐项执行以完成全面审计。

学会如何对网站做一次技术型SEO审计,以提升排名。列出今年你为搜索引擎优化(SEO)做过的三件事。

这些策略是不是都围绕着关键词研究、meta描述和外链?如果是,你并不孤单——在许多营销人开始做SEO时,这些通常是他们先上手的三种做法。

这些策略确实能提升网站在自然搜索中的可见度,但它们不是你唯一应当施行的手段。还有一类策略属于SEO范畴但更多是“幕后工作”,也同样关键。

技术型SEO就是指那些驱动有机增长引擎的幕后要素,例如站点结构、移动端优化和页面加载速度。这些方面可能不够“吸睛”,但其重要性不容忽视。

改进技术型SEO的第一步是了解当前状况——也就是执行一次站点审计(site audit)。第二步是据此制定计划,逐项解决短板。下面我们将详细说明这两步。

用有效的技术型SEO改善你的网站——从这次审计开始

什么是技术型SEO?

技术型SEO指所有能够让搜索引擎更容易抓取与索引你网站的技术性工作。技术型SEO、内容策略与外链建设三者协同作用,共同推动页面在搜索结果中的排名。

技术型SEO、页面内SEO与页面外SEO有何区别?

很多人把SEO拆成三类:页面内(On-Page)、页面外(Off-Page)和技术型(Technical)。下面简要说明各自的含义。

页面内SEO

页面内SEO指那些直接在页面上能控制并向搜索引擎(和读者)说明页面主题的元素,包括图片的alt文本、关键词使用、meta描述、H1标签、URL命名与站内链接等。因为这些内容都在你的网站上,所以你对它们拥有最大的控制权。

页面外SEO

页面外SEO通过外部信任信号告诉搜索引擎你的页面有多受欢迎和有用,最重要的表现形式是外链(backlinks)。

外链的数量与质量会提升页面的PageRank。在其他条件相同的情况下,拥有100个来自权威相关站点的高质量链接的页面,会优于只有50个这样链接的页面(或100个非相关链接的页面)。

技术型SEO

技术型SEO也是可控的,但更不直观、也更难掌握。它侧重网站的结构、可抓取性、性能、安全性等技术层面的优化。

为什么技术型SEO很重要?

你可能会想完全忽略这部分,而只专注内容与外链;但技术型SEO对有机流量至关重要。即便你的内容再详实、再有价值,如果搜索引擎抓取不到它、理解不了它,那么很少有人会看到这些内容。

打个比方:如果一棵树倒在无人听见的森林里,它会发出声音吗?没有扎实的技术型SEO基础,你的内容对搜索引擎而言就像那棵“无人听见的树”——发不出声。下面我们讨论如何让你的内容在互联网中被“响亮地听到”。

理解技术型SEO的结构

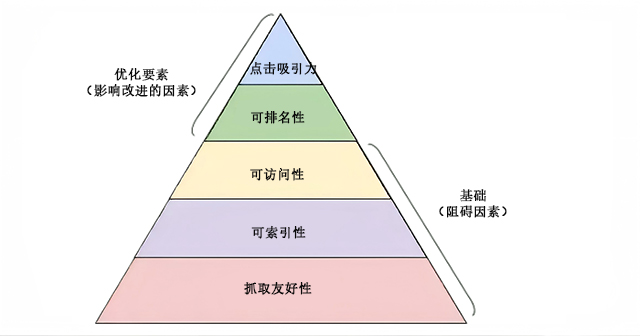

技术型SEO内容庞杂,最好把它分解成可执行的小块。如果你像我一样喜欢把大任务拆成清单来完成,那么好消息是:到目前为止我们讨论的所有内容大致可以归入五类,每一类都应有一套可操作的检查项与修复项。

这五类及其在技术型SEO层级中的位置,最直观的方式是用一张类似马斯洛需求层次的图来表示,不过这里我们把它改造成适用于搜索引擎优化的金字塔。(注:在后文中,我们将使用常用术语“Rendering(渲染)”来替代“Accessibility(可访问性)”。)

技术SEO的5个层次结构

技术型SEO审计基础

在开始技术型SEO审计之前,有几项基础工作需要先落实。我们先把这些基础要点讲清楚,再进入站点审计的其它内容。

审核并设置首选域名

域名是用户输入以访问你网站的地址,例如sukaseo.com。域名会影响用户通过搜索找到你站点的方式,也提供了识别站点的一致性。

当你选择首选域名时,就是在告诉搜索引擎你更希望在搜索结果中显示带www还是不带www的版本。例如,你可能希望优先显示www.yourwebsite.com而非yourwebsite.com。

这会提示搜索引擎优先展示www版本并把所有用户重定向到该URL。否则,搜索引擎可能把带www与不带www的两个版本当作不同站点来处理,导致SEO权重分散。正如SE Ranking在其技术型SEO问题分析中指出的那样,13.31%的网站仍存在未对www与非www版本进行重定向的问题。这也可能引发重复内容问题,降低SEO效果并影响排名。

以前Google要求站长明确首选URL版本;现在Google会自动识别并选择要展示的版本。但如果你希望手动指定首选域名,可以通过规范标签(canonical)来实现(后文会讲)。无论采用哪种方式,一旦确定了首选域名,请确保所有变体——包括www、非www、http以及index.html等——都永久重定向(301)到你选定的版本。

部署SSL

你可能听说过SSL(Secure Sockets Layer,安全套接字层),因为它非常重要。SSL在web服务器(负责响应在线请求的软件)与浏览器之间建立了一层加密保护,从而提高网站安全性。当用户向你的网站提交敏感信息(如支付或联系信息)时,启用SSL可显著降低被窃取或篡改的风险。

拥有SSL的站点URL以https://开头(而不是http://),并在浏览器地址栏显示为带锁图标的安全连接。搜索引擎会优先考虑安全站点:早在2014年,Google就宣布SSL会成为排名因素之一。因此,请把HTTPS版本的首页设置为你的首选域名。

在部署SSL后,你需要把所有非SSL(HTTP)页面迁移到HTTPS。虽然工作量不小,但为了提升排名这是值得的。常见迁移步骤包括:

- 将所有http://yourwebsite.com页面301重定向到https://yourwebsite.com。

- 相应更新所有的canonical与hreflang标签,确保指向HTTPS版本。

- 更新站点地图中的URL(通常位于yourwebsite.com/sitemap.xml)以及robots.txt(位于yourwebsite.com/robots.txt)中引用的所有地址为HTTPS。

- 在Google Search Console和Bing Webmaster Tools中为你的HTTPS站点创建新的站点实例并开始跟踪,以确认流量已完整迁移(目标是100%流量迁移到HTTPS)。

优化页面加载速度

你知道网站访客愿意等你的网站加载多久吗?大约六秒——而这个估计已经相当宽松。有研究显示,当页面加载从1秒增加到5秒时,跳出率会增加约90%。时间非常宝贵,所以提升站点加载速度应当列为优先事项。

页面速度不仅影响用户体验与转化率,也是影响排名的因素。下面这些实用建议可帮助你缩短平均页面加载时间:

- 对所有资源进行压缩:压缩可以减小图片、CSS、HTML与JavaScript等文件体积,从而减少传输时间,加快加载。

- 定期审查重定向:每一个301重定向都需要额外的请求时间。层层重定向或多个页面重复重定向会显著拖慢加载速度,应尽量精简重定向链路。

- 精简代码:冗余或结构混乱的代码会降低页面性能。像写文章一样,一稿可能用6句表达,精简后只需3句;代码也应尽量高效。清理后再进行minify(代码精简)与压缩处理。

- 考虑使用内容分发网络(CDN):CDN在全球多个节点缓存你的网站副本,并根据访问者的地理位置就近响应请求,从而缩短传输距离,提高加载速度。

- 谨慎使用插件:过多或过旧的插件往往带来安全隐患和性能问题。只保留必要插件并及时更新;优先考虑定制主题或轻量化方案,避免预制主题中不必要的冗余代码。

- 利用缓存插件:缓存插件会为回访用户提供静态页面版本,减少动态生成的开销,从而缩短重复访问时的加载时间。

- 使用异步(async)加载脚本:脚本通常会阻塞HTML的解析与渲染(例如放在<head>中的第三方脚本),使用async可让浏览器并行下载并执行脚本,减少阻塞。示例:<script async src=”script.js”></script>

如果你想要评估站点在速度方面的表现,可以使用Google提供的相关检测工具来查看问题点与优化建议。

一旦完成了技术型SEO的基础工作,就可以进入下一阶段——抓取友好性(crawlability)的检查与优化。

抓取友好性检查清单

抓取友好性是技术型SEO策略的基石。搜索爬虫会抓取你的网站以收集站点信息;如果爬虫被阻挡,页面就无法被索引或排名。实施技术型SEO的第一步是确保所有重要页面对爬虫可访问且易于发现与导航。

下面我们将列出应加入审计清单的项目,以及需要审核的网站要素,确保页面准备就绪以供抓取。

- 创建XML站点地图

- 最大化抓取预算

- 优化站点架构

- 设定URL结构

- 使用robots.txt

- 添加面包屑菜单

- 使用分页

- 检查SEO日志文件

创建XML站点地图

还记得我们前面提到的网站结构吗?它应该反映在一个叫做XML站点地图的文件中,帮助搜索爬虫理解并抓取你的网站页面。

把站点地图想象成网站的“地图”。站点地图完成后,应提交到Google Search Console与Bing Webmaster Tools。随着页面的增加或删除,别忘了及时更新站点地图。

最大化抓取预算

抓取预算指的是搜索爬虫愿意抓取你站点的页面与资源总量。由于抓取预算不是无限的,请优先确保重要页面被优先抓取。以下是一些最大化抓取预算的建议:

- 删除或对重复页面做规范化。

- 修复或重定向所有断链。

- 确保CSS与JavaScript文件可被抓取(非被阻挡)。

- 定期检查抓取统计,关注突发的下降或上升。

- 确认你在robots.txt或meta robots中明确禁止抓取的bot或页面确实是有意为之。

- 保持站点地图更新并提交到相应站长工具。

- 清理站点中不必要或过时的内容。

- 注意动态生成的URL,这类URL会使站点页面数量急剧膨胀,从而浪费抓取预算。

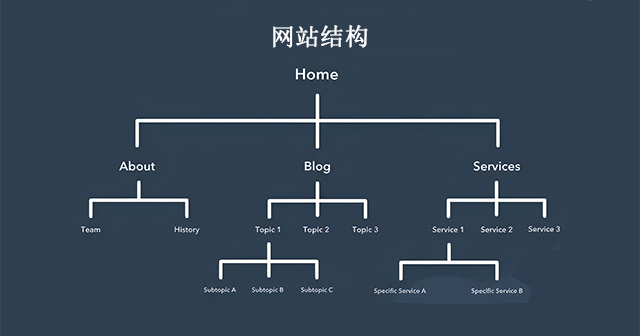

优化站点架构

你的网站包含多个页面,这些页面应按便于搜索引擎发现与抓取的方式组织,即所谓的信息架构。就像建筑需要设计,站点架构决定页面之间如何组织与关联。

相关页面应当分组,例如博客首页链接到每篇文章,文章再链接到作者页;这种结构能帮助搜索爬虫理解页面间的关系。

站点架构还应反映页面的重要性:页面A离首页层级越近、指向页面A的内部链接越多、这些链接所携带的权重越高,搜索引擎就会认为页面A更重要。

举例而言,首页直达的链接通常比某篇博客文章内的链接更能传递权重。确保对业务最重要的页面处于层级顶端,并获得尽可能多的(且相关的)内部链接。

网站架构

设定URL结构

URL结构指的是你如何构建URL,通常与站点架构相关联。URL可以使用子域(如blog.example.com)或子目录/子文件夹(如example.com/blog)来表示层级与归属。

举例:一篇标题为How to Groom Your Dog的博客文章可能对应www.bestdogcare.com/blog/how-to-groom-your-dog,而产品页可能是www.bestdogcare.com/products/grooming-brush。

是否采用子域或子目录、使用products还是store,都由你决定;关键是保持一致,不要在不同页面间混用blog.yourwebsite.com与yourwebsite.com/blogs。为URL命名制定统一规则并坚持执行。

编写URL的一些建议:

- 使用小写字母。

- 用短横线(-)分隔单词。

- 保持简短且具描述性。

- 避免不必要的字符或词(包括多余的介词等)。

- 在合适处包含目标关键词。

当你的URL结构确定后,把重要页面的URL列入XML站点地图并提交给搜索引擎,这样可以为爬虫提供额外线索,减少它们在抓取时的猜测成本。

使用robots.txt

当爬虫访问你的网站时,会首先检查根目录下的/robots.txt(机器人协议)。该协议用于允许或禁止特定爬虫抓取站点的某些区域或页面。若你希望某些页面不被索引,应使用meta robots的noindex标签(后面示例有说明)。下面分两个场景说明:

阻止恶意或不想要的爬虫

有些爬虫带有恶意意图——会刮取你的内容或在论坛/评论区灌水。遇到这种情况,可以在robots.txt中针对特定User-agent写Disallow规则来阻止它们访问。把robots.txt想象成对恶意爬虫的第一道防线。不过要注意,robots.txt是一项礼貌规范,恶意爬虫可能会忽视它。

控制索引与节省抓取预算

搜索爬虫在抓取时会判断页面是否有助于理解站点主题,但抓取预算有限。因此,你通常应该排除那些对搜索爬虫无价值的页面,例如促销后的Thank-You页面、登录页或其他非公开页面,以避免浪费抓取预算。

对于真正不希望被索引的页面,应在页面<head>中使用noindex元标签,例如:

<meta name="robots"content="noindex"/>总之,/robots.txt的具体配置应根据你的站点目标来定制——确保允许重要资源(如CSS/JS)被抓取,同时屏蔽不需要被搜索引擎检索的区域。

添加面包屑菜单

记得《汉塞尔与格蕾特》里孩子们用面包屑找到回家的路吗?网站的面包屑(Breadcrumb)也是类似的导航线索:它告诉用户当前页面在网站结构中的位置,便于返回上层目录。面包屑对用户友好之外,同样对搜索爬虫有帮助。

面包屑应满足两个条件:

- 对用户可见,便于用户在站内导航,无需频繁点击后退按钮;

- 包含结构化标记,以便爬虫准确理解页面之间的层级与关系。

如果需要为面包屑添加结构化数据,可使用BreadcrumbList(JSON-LD格式)。示例(简化):

<script type="application/ld+json">

{

"@context":"https://schema.org",

"@type":"BreadcrumbList",

"itemListElement":[

{"@type":"ListItem","position":1,"name":"首页","item":"https://www.example.com/"},

{"@type":"ListItem","position":2,"name":"产品","item":"https://www.example.com/products"},

{"@type":"ListItem","position":3,"name":"产品详情","item":"https://www.example.com/products/sku"}

]

}

</script>使用结构化数据可提高搜索结果中面包屑展示的概率(并为爬虫提供明确语义)。

使用分页

分页(Pagination)类似于论文页码,用来组织序列化或分章节的内容(例如文章系列、产品列表等)。在技术型SEO中,分页通过代码告诉搜索引擎具有各自独立URL的一系列页面是相互关联的,从而帮助爬虫更好地发现并抓取这些页面。

常见做法是在系列页面的<head>中使用rel=”next”与rel=”prev”:

在第1页的<head>中:

<link rel="next"href="https://www.website.com/page-two"/>在第2页的<head>中:

<link rel="prev"href="https://www.website.com/page-one"/>

<link rel="next"href="https://www.website.com/page-three"/>需要注意的是:分页对抓取发现仍然有帮助,但Google已不再像以前那样利用rel=”prev/next”来批量索引分页系列。

因此,分页主要用于改善发现与导航,而不是保证批量索引。实现分页时,同时关注用户体验与内部链接策略,确保分页页之间的导航清晰、对用户友好,并尽量避免生成大量重复或低价值页面。

检查SEO日志文件

可以把日志文件想象成网站的“日记”。Web服务器(即“记日记的人”)会把它对站点的每一次操作记录在日志文件(即“日记”)中。日志中通常记录的信息包括请求的时间与日期、所请求的资源、请求方的IP地址,以及User-Agent(用户代理——一种能唯一识别请求来源的软件,例如某个搜索爬虫)。

这和SEO有什么关系?

当搜索爬虫抓取你的网站时,会在日志里留下足迹。通过检查日志并按User-Agent或搜索引擎筛选,你可以确定爬虫是否抓取了你的网站、何时抓取、抓取了哪些页面。

这些信息对你很有价值:它能帮助你判断抓取预算的使用情况,以及爬虫在抓取或访问时遇到了哪些阻碍。要获取日志文件,你可以让开发人员提供,或使用日志分析工具(例如Screaming Frog的日志分析器)来处理和可视化这些数据。

注意:仅仅能被爬虫抓取并不代表页面就一定能被索引。接下来我们进入技术型SEO审计的下一层——索引能力(Indexability)。

索引能力检查清单

当搜索爬虫抓取你的网站后,会根据页面主题与相关性将页面加入索引。一旦页面被索引,就有资格出现在SERP(搜索引擎结果页)中。以下是帮助页面成功被索引的关键因素与检查项。

- 解除对重要页面的爬取限制

- 删除或规范化重复内容

- 审核重定向设置

- 检查站点的移动端响应性

- 修复HTTP错误

解除对重要页面的爬取限制

这一步通常会在抓取友好性(crawlability)阶段处理,但在索引层面也非常重要。确保爬虫可以自由访问你希望被索引的页面,并且这些页面是指向首选版本的。

你可以使用以下工具来确认并定位被阻止的页面:Google的robots.txt测试工具会列出被禁止抓取的路径;Google Search Console中的URL检查(Inspect/URL Inspection)工具可以帮助诊断页面被阻止的具体原因。

删除或规范化重复内容

重复内容会让爬虫产生混淆,进而影响索引。记得使用canonical(规范)标签来声明首选页面,避免重复内容导致索引分散或错误。

审核重定向

确认所有重定向配置是否正确。重定向环路、指向不存在的URL(Broken Redirects),或错误的重定向行为都会在索引过程中引发问题。因此应定期审计站点上的重定向,确保使用正确的301/302等并避免链路过长。

检查移动端适配

如果你的网站还没有实现移动友好(mobile-friendly),那就落后了。早在2016年,Google就开始实行移动优先索引(mobile-first indexing),并逐步将移动体验作为优先考量。

现在移动优先是默认行为。使用Google的移动友好性测试(Mobile-Friendly Test)来检测并修复移动端页面存在的问题。

修复HTTP错误

HTTP错误(如4xx、5xx)会阻止页面被正常抓取或索引。定期扫描并修复这些错误,确保搜索爬虫与用户都能顺利访问重要页面。

HTTP是超文本传输协议(HyperText Transfer Protocol),虽然你可能不关心这个全称,但你一定关心当HTTP返回错误给用户或搜索引擎时该如何处理。HTTP错误会阻碍爬虫访问你站点上的重要内容,因此必须尽快且彻底地修复。

由于每种HTTP错误的成因不同、解决方法也不一样,下面对常见状态码做简要说明,并给出处理方向:

- 301永久重定向:用于将流量永久性地从一个URL转到另一个URL。CMS通常支持配置此类重定向,但过多重定向会增加页面加载时间并影响用户体验。尽量避免重定向链(redirect chains),因为链条过长可能会导致搜索引擎中止抓取该页面。

- 302临时重定向:将流量临时转到另一个页面。虽然302会把用户导向目标页面,但缓存的标题、URL与描述仍会保留原始URL的信息。如果临时重定向持续时间过长,最终可能被视为永久重定向,其链接与索引信号会传递到目标URL。

- 403禁止访问:表示所请求的资源基于权限配置被禁止访问,或者服务器出现配置问题。

- 404页面未找到:告知用户所请求的页面不存在,可能是页面已删除或输入了错误的URL。建议为404页面设计符合品牌且友好的页面,以降低跳失并引导用户到其他有价值内容。

- 405方法不被允许:服务器识别了请求的方法(如GET、POST等),但仍阻止该方法访问资源,从而返回错误。

- 500服务器内部错误:通用错误,表示服务器在处理请求时遇到问题,未能成功响应。

- 502错误网关:表示服务器之间通信出现异常或返回了无效响应。

- 503服务不可用:通常表示服务器当前无法处理请求(例如过载或维护中),但服务器本身仍在运行。

- 504网关超时:表示代理或网关在限定时间内未从后端服务器得到及时响应。

无论哪种错误,都应尽快修复,以维护用户体验与搜索引擎对你站点的信任度。即便页面已被抓取与索引,阻碍用户或爬虫访问的可用性问题仍会影响SEO。接下来,我们进入技术型SEO审计的下一阶段——可渲染性(Renderability)。

可渲染性检查清单

在深入本主题前,需要区分SEO可访问性与网站无障碍。后者关注的是为有视觉障碍、阅读障碍(如阅读障碍)等残障用户提供无障碍浏览体验,许多无障碍方案与SEO的最佳实践存在重合。但SEO可访问性审计并不能涵盖所有使网站对残障用户友好的措施。

本节我们重点关注SEO角度的可访问性,也就是渲染:确保搜索引擎与AI模型能够正确渲染并理解页面内容。在后续章节中,我们会提供针对渲染问题的检查项与可操作建议;同时也提醒你在开发与维护站点时将网站无障碍纳入长期考量。

一个对搜索引擎友好的站点,首先要保证页面容易被渲染。下面列出在可渲染性审计中需要检查的网站要素。

服务器性能

如前面所述,服务器超时或故障会引发HTTP错误,妨碍用户与爬虫访问站点。如果发现服务器存在问题,应及时使用前文提到的资源进行排查与修复。若长期忽视,搜索引擎可能会将有问题的页面从索引中移除——向用户展示损坏页面会造成糟糕体验。

HTTP状态

与服务器性能相关,HTTP错误会阻止对页面的访问。可以使用网站爬虫工具(如Screaming Frog、Botify或DeepCrawl)对全站进行全面的错误审计,找出4xx/5xx等问题并修复。

加载时间与页面体积

页面加载过慢不仅会提升跳出率,还可能导致服务器错误,阻止爬虫完整抓取页面或使其只抓取到部分加载内容(缺失关键段落)。爬虫在尝试加载、渲染与索引页面时会根据资源需求消耗相应的抓取资源,因此你应尽一切可能缩短页面加载时间,减小页面体积。

JavaScript渲染

Google本身对JavaScript(JS)的处理存在一定挑战,因此建议尽量采用预渲染(pre-rendering)来提升可访问性。Google也提供了多种资源,帮助你理解爬虫如何访问站点上的JS内容,以及如何修复与JS相关的搜索问题。

若核心内容依赖客户端JS才能呈现,应考虑服务端渲染(SSR)、预渲染或降级策略以确保爬虫与AI能看到完整内容。

孤立页面

站点中每个页面至少应由另一个页面链接到——且重要页面应有更多内部链接支撑。没有任何内部链接指向的页面称为“孤立页面”,这类页面缺少上下文,爬虫难以判断其在站点中的定位与重要性,从而影响索引与排名。

页面深度

页面深度指页面在站点结构中的层级,也就是距离首页需要点击的次数。尽量保持站点结构扁平,同时保证逻辑清晰。有时多层结构不可避免,但在设计时应优先考虑组织性与可发现性。

通常建议把关键页面(如产品页、联系方式页)控制在不超过3次点击深度内;如果把产品页埋得很深,用户与爬虫都很难找到,体验与可访问性都会下降。举个糟糕的站点结构示例(不推荐):

www.yourwebsite.com/products-features/features-by-industry/airlines-case-studies/airlines-products

重定向链

当你把流量从一个页面重定向到另一个页面时,会付出代价:抓取效率会下降。重定向会拖慢抓取速度、增加页面加载时间,若配置不当还可能让网站变得不可访问。因此尽量将重定向控制在最低限度内。解决可访问性问题后,我们进入如何提高页面在搜索结果中排名的部分。

可排名性检查清单

接下来我们将进入你可能已经熟悉的主题部分——如何从技术SEO的角度提升排名。让页面获得更好的排名,既涉及到前面提到的站内和站外因素,但这里我们会专注于用技术视角来解读。

请记住,这些要素并不是独立存在的,而是相互配合,共同构建一个对搜索引擎友好的网站。因此,我们不能忽视任何一个影响因素。现在,让我们深入探讨吧。

站内与站外链接

链接帮助爬虫判断某个页面在查询语境中的位置,并提供排名参考。链接为爬虫(和用户)指示相关内容并传递页面重要性。总体而言,合理的链接结构能改善抓取、索引,并提升排名能力。

反向链接质量

反向链接(即其他站点指向你站点的链接)相当于对你站点的信任投票。当这些投票累积到一定程度时,爬虫会认为你的网站更具权威性和可信度。但需要注意:外链的质量极为重要。

来自低质量站点的链接可能反而损害你的排名。获取高质量外链的方式包括:对相关媒体/出版物做外联、索回未加链接的引用、以及产出有价值的内容让别人主动愿意链接。

内容集群

我们一直倡导内容集群策略。内容集群将主题相关的页面连接起来,让搜索爬虫更容易发现、抓取并索引你在某一主题上所有的页面。

集群结构向搜索引擎展示你在某个主题上的深度与覆盖,有助于建立权威,从而提高相关查询的排名机会。

你的“可排名性”决定了自然流量的增长潜力——研究显示,搜索结果页面的前三名更容易吸引点击。那么,如何让你的结果成为被点击的那一个呢?下面进入“点击能力”相关内容。

点击能力检查清单

虽然点击率(CTR)很大程度上取决于搜索者的行为,但你仍然可以通过一系列技术与结构化手段提高在SERP中的吸引力。除了元描述与标题之外,还有一些技术性举措能使你的结果更显眼。我们重点讲技术层面:

- 使用结构化数据

- 争取SERP特性

- 优化以获得精选摘要

- 考虑Google Discover的流量机会

排名与点击率密切相关:搜索者想要直接得到答案,你的结果越突出,被点击的几率越高。下面逐项说明如何提升点击能力。

使用结构化数据

结构化数据使用一种被称为schema的词汇表来标注页面上的元素,明确每个字段的类型与含义。Schema会让爬虫清楚地知道“这是视频”、“这是产品”或“这是食谱”等等,从而消除歧义。

需要说明的是,结构化数据本身并非直接的“点击因素”,但它能以更易被理解的方式组织内容,帮助搜索引擎更准确地索引与展示你的页面,从而间接提升在SERP中被展示为富结果或特色展示的机会。

争取SERP特性

SERP特性(也称富结果)是一把双刃剑:如果你获得了这些特性并能吸引点击,那收益非常可观;反之,如果没有获得,普通自然结果会被置于页面下方,出现在付费广告、文本答案框、视频轮播等元素之下,从而显著降低曝光与点击机会。

富结果是指不按常规标题+URL+meta描述格式展示的搜索结果。例如,下图中就展示了两个SERP特性:视频轮播和“人们也会问”(People Also Ask)框,这些都位于首条自然结果之上。

虽然在顶级自然结果仍有机会获取点击,但获得富结果能大幅提升被点击的概率。

如何提高获得富结果的概率?核心是:产出有价值的内容并使用结构化数据。结构化数据让爬虫更容易理解页面内的各类元素,从而提高你进入富结果的机会。结构化数据有助于站点在搜索画廊(Search Gallery)中的多种展示,常见可助力获得富结果的类型包括:

- 文章(Articles)

- 视频(Videos)

- 评论(Reviews)

- 活动(Events)

- 操作指南(How-Tos)

- 常见问答(FAQs/“People Also Ask”)

- 图片(Images)

- 本地商家信息(Local Business Listings)

- 商品(Products)

- 站点链接(Sitelinks)

优化以获得精选摘要

一种与schema标记无直接关系的“独角兽”级SERP特性是精选摘要(Featured Snippets):那些位于搜索结果顶部、直接给出简洁答案的框。

精选摘要的目标是尽快为搜索者提供问题的答案。

Google表示:提供对搜索者提问的最佳答案是赢得精选摘要的关键。不过,我们研究也发现了一些额外可行措施,用于提升内容获得精选摘要的可能性(例如答案格式化、直接回答问题的段落、使用清晰的小标题与列表等)。

关注Google Discover

Google Discover是面向移动用户、按类别向用户推荐内容的算法化内容流。考虑到移动端搜索占比已超过50%,Google在移动体验上的投入不断加码也就不足为奇。Discover允许用户通过选择兴趣类别(例如园艺、音乐或政治)来构建个性化内容库。

我们认为主题聚类能提高被Google Discover推荐的概率,目前也在通过Search Console监测Discover流量以验证这一假设。

建议你也研究并投入时间准备Discover的内容机会:回报是获取高度参与、主动订阅你内容的移动用户群体,这些用户相当于“亲自挑选”了你辛苦创作的内容。

技术型SEO、页面内SEO与页面外SEO三者协同运作,才能真正打开有机流量之门。页面内与页面外的策略通常是多数人先部署的部分,但技术型SEO在把你的网站推到搜索结果顶部、并将内容展示给目标受众方面起着关键作用。将这些技术策略融入你的整体SEO计划,耐心观察成效,你将看到排名与流量的改善。