技术型SEO不是玄学,也不是单靠关键词就能解决的事。它更多是网站的“底层功夫”——从加载速度、抓取权限到结构化数据与hreflang,每一个细节都影响搜索引擎如何理解与呈现你的网站。本文按步骤讲清8个必须掌握的技术点,配上可落地的检查项,帮你把网站从“被忽视”变成搜索引擎的“宠儿”。

在这篇文章里,我们会讲解技术型SEO的基础知识。说到“基础的技术性内容”听起来好像有点自相矛盾,但了解一些技术方面的常识,往往能决定你的网站是高居榜首还是根本排不上名。技术型SEO并不简单,但我们会用通俗的语言说明:在构建网站技术基础时,你(或你的开发人员)应该关注哪些要点。

什么是技术型SEO?

技术型SEO指的是通过优化网站的技术层面来提升网页在搜索引擎中的排名。让网站更快、便于抓取、让搜索引擎更容易理解页面内容,是技术优化的核心。技术型SEO属于页面内SEO(on-page SEO)的一部分,专注于改善网站自身的元素以获得更高排名;这与页面外SEO(off-page SEO)相对,后者主要是通过外部渠道为网站带来曝光。

为什么要做技术型优化?

Google等搜索引擎希望为用户呈现最相关、体验最好的结果。因此,Google的爬虫会从多个维度抓取并评估网页,其中一些维度与用户体验有关(比如页面加载速度),另一些维度则帮助搜索引擎判断页面内容(比如结构化数据)。通过改进这些技术层面的内容,你能让搜索引擎更顺利地抓取和理解你的网站;如果做得好,可能会获得更高的排名,甚至有机会出现富摘要(rich results)。

反过来,技术错误也会带来严重后果。你绝不是第一个因为robots.txt文件里多写了一个斜杠(trailing slash)就完全把搜索引擎挡在站外的人——这种低级错误会导致爬虫被拒之门外。

但别误会,技术优化不是为了讨好搜索引擎而做的折中方案。网站首先应该为用户服务:快速、清晰、易用。好在很多时候,打好技术基础恰好也能同时改善用户体验与搜索引擎体验。

技术优化网站的特征

一个技术上健全的网站对用户来说打开快、对搜索引擎的爬虫来说易于抓取。合理的技术设置能帮助搜索引擎理解网站主题,也能避免例如重复内容引起的混淆。它还可防止用户或搜索引擎因为无效链接被引到死胡同。下面简要介绍一个技术优化良好的网站应具备的几个重要特征。

1、打开速度快

如今网页必须要加载迅速。用户耐心有限,不愿等待页面打开。早在2016年的研究就表明:如果网页在3秒内未打开,53%的移动端访客会离开。这个趋势没有消失——2022年的研究显示,电商网站的转化率每多等待一秒,大约下降0.3%。所以,如果你的网站很慢,用户会流失到竞争对手那里,你也会错失大量流量。

Google也意识到慢速页面会带来较差的体验,因此倾向于优先展示加载更快的页面。换言之,慢页面往往会被排在搜索结果靠后的位置,流量进一步减少。自2021年起,页面体验(Page Experience)已成为Google的正式排名因素,所以保证页面足够快比以往任何时候都重要。

想知道你的网站够不够快?可以学习如何轻松测试站点速度。大多数测速工具会同时给出需要改进的建议。你还可以查看核心网页指标(Core Web Vitals)——Google用它们来衡量页面体验。另外,我们也整理了常见的网站速度优化建议,供你参考。

2、对搜索引擎可抓取

搜索引擎会用爬虫(robots/spiders)来抓取你的网站,爬虫通过追踪链接发现站内内容。良好的内部链接结构能确保爬虫把网站中最重要的内容优先抓取和理解。

除此之外,还有多种方法可以引导爬虫行为。比如,你可以阻止爬虫抓取某些不希望被抓取的内容;也可以允许抓取但告知爬虫不要把该页显示在搜索结果中,或不要追踪该页上的链接。

robots.txt文件

你可以通过robots.txt文件向爬虫发出抓取指令。这是一个强大且需要谨慎使用的工具。正如前文所说,一个小错误就可能导致爬虫无法抓取(网站的重要部分)。有时站长会不小心在robots.txt中屏蔽掉站点的CSS或JS文件,而这些文件告诉浏览器页面应如何展示和运作。如果这些被屏蔽,搜索引擎就无法判断页面是否正确呈现,从而影响索引与排名。

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Sitemap: https://sukaseo.com/sitemap_index.xml总的来说,如果你想深入了解robots.txt的工作原理,建议认真学习它的用法;或者更稳妥的是,让开发人员来处理这类配置。

Meta robots标签

robots元标签是一段你在页面前端看不到的代码,它存在于页面源代码的<head>区。当搜索引擎爬虫抓取页面时,会读取<head>的内容,从而知道这个页面里有什么以及应该如何处理它。

<meta name="robots" content="follow, index"/>如果你希望搜索引擎抓取某个页面,但出于某些原因不希望它出现在搜索结果中,可以通过robots元标签告诉爬虫。通过这个标签,你还可以指示爬虫抓取页面但不要跟踪(follow)该页面上的链接(也就是nofollow的行为)。

3、没有(太多)死链

慢页面固然让人烦躁,但更令访客抓狂的是点开一个不存在的页面。如果链接指向站内不存在的页面,用户会看到404错误页——你精心设计的用户体验瞬间崩塌。

搜索引擎也不喜欢发现大量错误页面。实际上,爬虫往往比真实访客能发现更多死链,因为它们会追踪页面上遇到的每一条链接——即便那些链接是隐藏的。

大多数网站都或多或少存在死链问题,网站本就是不断更新和迭代的过程:有人创建东西,也有人不小心弄坏东西。幸好,有工具可以帮你找出站内死链并给出修复方案(如何处理404错误等)。

为了避免不必要的死链,删除或移动页面时应总是设置重定向(redirect)。理想情况下,把旧页面重定向到能够替代或相关的页面,而不是直接让用户遇到404。

4、不会用重复内容“搞糊涂”搜索引擎

当同一内容出现在站内多处甚至在不同网站上时,搜索引擎就会困惑:哪个页面应该排名更高?结果可能是把这些页面的排名都拉低。

更麻烦的是,你可能并不知道自己已经有了重复内容问题。出于技术原因,不同的URL也可能呈现同样的页面内容——对访客来说没问题,但对搜索引擎而言,它们会把相同内容视为多个独立页面。

<link rel="canonical" href="https://sukaseo.com/" />解决办法很技术化也很有效:使用所谓的canonical(规范化)链接元素(即rel=”canonical”)。通过canonical,你可以明确告诉搜索引擎哪个页面是内容的“原始”或“首选”版本,也就是你希望被收录和排名的那个URL。这样,搜索引擎就不会把相似页面当成重复内容从而影响排名。

5、安全性

技术优化良好的网站同时也是安全的网站。如今确保用户数据和隐私安全已是基本要求。做很多事情都能提升你(尤其是WordPress)网站的安全性,其中最关键的一项就是启用HTTPS。

HTTPS可以保证浏览器与网站之间传输的数据不会被第三方窃听或篡改。例如用户在你站点登录时,其凭证会被加密保护。要启用HTTPS,你需要为站点安装SSL证书。Google也重视安全性,把HTTPS作为一个排名信号:安全站点比不安全站点更容易获得更高排名。

在大多数浏览器中,你可以很容易检查站点是否启用了HTTPS:地址栏左侧会出现一把锁,表示安全;如果显示“Not secure(不安全)”,那说明你或你的开发者需要处理这项工作。

6、结构化数据

结构化数据能帮助搜索引擎更准确地理解你的网站、内容或业务。通过结构化数据,你可以告诉搜索引擎你在卖什么产品、页面包含哪些食谱等,并提供这些项目的详细属性。

这些信息应按Schema.org规范的固定格式提供,便于搜索引擎读取并把你的内容放到更大的语义图景中。实施结构化数据的额外好处是:它能让你的页面有机会在搜索结果中以富摘要(rich results)形式展示——比如评分星级、价格、做法详情等,更醒目也更能吸引点击。

7、XML站点地图

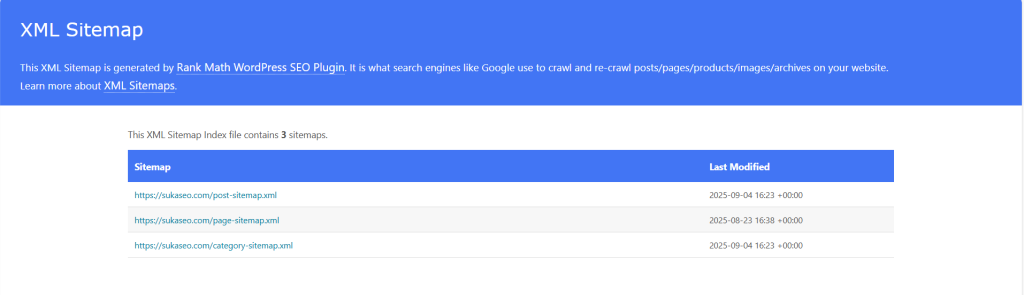

简单来说,XML站点地图是一个列出网站所有页面的清单,作用相当于给搜索引擎的站点路线图。借助站点地图,你可以确保搜索引擎不会漏掉站内的重要内容。XML站点地图通常会按文章、页面、标签或自定义类型分类,并为每个页面包含图片数量、最后修改时间等信息。

XML站点地图

理论上,如果网站内部链接结构非常完善,Robots可以通过内链发现全部内容,站点地图并非必需。但现实中并非所有站点都具备理想结构,有XML站点地图总不会有坏处。因此我们通常建议网站保留一份XML站点地图。

8、国际化站点使用hreflang

如果你的网站面向多个国家或在多个使用同一语言的地区运行,搜索引擎需要额外信息来判断每个页面适合显示给哪个国家或语言的用户。帮助搜索引擎判断后,他们就能在搜索结果中把最合适的版本展示给相应地区的用户。

hreflang标签就是用来做这件事的:通过它你可以为每个页面标明目标国家和语言。这也能解决一种可能的重复内容问题:即便美国站和英国站显示相同内容,Google会知道它们是为不同地区准备的,从而避免误判为重复内容。

优化国际化站点是一个专门领域。